Aunque el título probablemente no le dé más que curiosidad, cuando se habla de Ollama, hablamos de inteligencia artificial (IA); pero a diferencia de Chatgpt o Copilot. Ollama es básicamente una IA “corriendo” o ejecutándose en su computadora (PC). Sin la necesidad de conectarse a Microsoft u OpenAI; que almacenan, analizan e integran sus conversaciones en sus servicios.

Obviamente para muchas personas o empresas la privacidad es importante, por lo que tener disponible Ollama en su propio equipo y offline, representa una ventaja.

Si usted alguna vez leyó sobre sobre Chatgpt o Copilot más a fondo, probablemente en algún momento se encontró con la abreviatura LLM. Esta, hace referencia a los grandes modelos de lenguaje (LLM, por sus siglas en ingles).

A estos LLM muchas veces les ponen nombres “exóticos” o curiosos, como lo son:

- Vicuna.

- Llama.

- Mistral y muchos otros.

Los LLM son básicamente conjuntos grandes de información (documentos, libros, imágenes, videos, etc.), que han sido procesados mediante técnicas matemáticas, estadísticas y computacionales, para que una computadora muy potente (o un conjunto de computadoras) sea capaz de manipular y procesar este conjunto de información y de esta manera tener un chat o una conversación con la IA, lo más parecido a como lo harían un par de seres humanos.

Los LLM existen en varios tamaños, generalmente se miden en billones de parámetros con los cuales han sido entrenados. Así, por ejemplo: tenemos LLM de 7, 13, 70… billones de parámetros.

Es importante destacar que ha mayor cantidad de parámetros en el LLM, mayor sería la “potencia” requerida por la computadora, para manejar el LLM. En la actualidad, muchos de estos modelos (LLM) están siendo optimizados para utilizar menos recursos (computadoras menos potentes) y ahora es posible correr modelos (al menos los de tamaño 7B) en computadoras de escritorio con al menos 8 GB de RAM y un procesador “decente”.

En este punto, no voy a profundizar mucho en los requerimientos ideales para manejar los LLM, por que probablemente no tengamos un tope en lo que debe tener una compu para manejar un modelo de manera rápida, efectiva y confiable.

Después de tanta hablada, vamos a implementar nuestra propia IA, en nuestra propia compu, sin necesidad de sacrificar nuestra privacidad. Para esto vamos a utilizar un software llamado Ollama, el cual descargaremos e instalaremos como cualquier otro software. Link de descarga(https://ollama.com/download/OllamaSetup.exe).

Por defecto, este mentado Ollama, incorpora el modelo llamado llama3.

Una vez instalado Ollama en nuestra compu, veremos el icono de una llama por donde está ubicado la fecha o el icono de su wifi en el escritorio Windows. Esto quiere decir que ya estamos listos para conversar con Ollama.

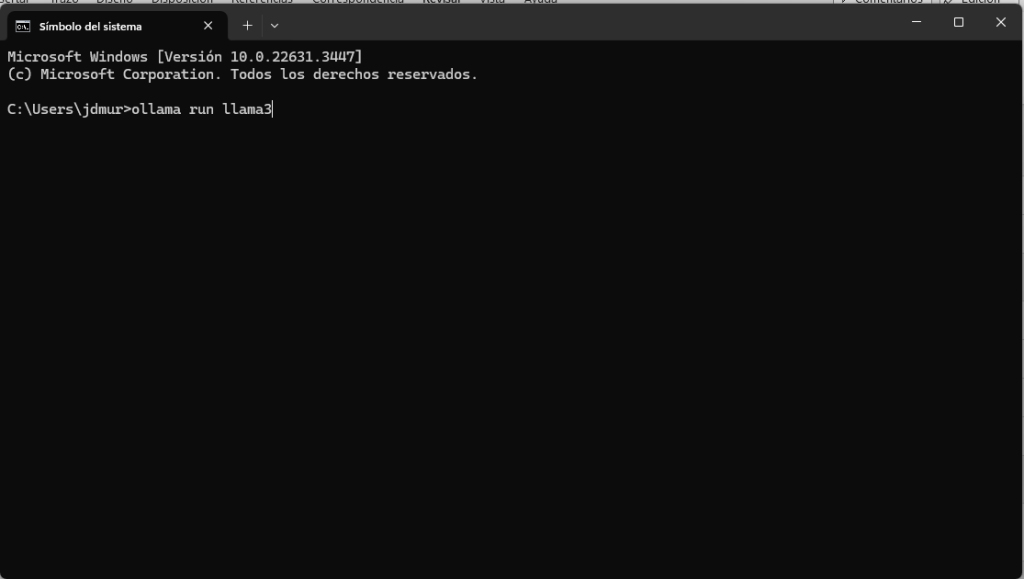

Para poder iniciar una conversación con nuestra IA debemos ir a la terminal o cmd. Esto lo logramos presionando el botón con el icono de Windows en nuestro teclado y digitando las letras cmd, lo que dará paso a la pantallita negra y ahí digitaremos:

ollama run llama3

Usted al correr ollama run llama3 el programa empieza a cargar el LLM llamado llama3 que pesa casi 5 GB, por lo que debera esperar un poco de acuerdo a la velocidad de su internet.

De esta manera y como dicen… en dos platos, ya puede iniciar la conversación.

Hasta este punto, si ya usted está conversando con su computadora, pues lo felicito y le incentivo a preguntarle cosas que pudieran ayudarle a mejorar la atención de sus pacientes en la farmacia.

Aprovechando le hice la siguiente pregunta a Ollama: ¿Como me puede ayudar Ollama a mejorar como farmacéutico?, esta fue la respuesta.

Para finalizar, quisiera decirle que existen maneras de “setear” este software para hacerlo más personalizado, pero con el fin de no alargar este post, lo dejaré para otra entrega.

Espero me puedan contar como les fue con esta tecnología.

4 respuestas a «Ollama para farmacéuticos (Si, inteligencia artificial)»

Excelentes aportes, Gracias

Con gusto.

De. Usted es un genio de la computación y además no tiene reparo en compartir su conocimiento

Confío que Dios lo seguirá inspirando para continuar ayudando a sus colegas

Gracias por sus palabras Xinia, la verdad cada día hay más proyectos bonitos relacionados con la inteligencia artificial y el poder explorarlos es algo que me divierte bastante